Sales thì có CRM, kế toán có phần mềm kế toán, nhân sự có HRM, còn Marketing thì có gì?!

Marketers thường có… hàng chục tab Google Chrome, các file Excel tải về từ đủ mọi nguồn dữ liệu, và hàng loạt công cụ lẻ tẻ khác nhau: từ Meta Ads, Google Ads, TikTok Ads đến Google Analytics, CRM, Fanpage insights, các trang thương mai điện tử Shopee, Tiktok, Lazada,… và hàng loạt file Excel tải về khác.

Nhìn chung, dữ liệu của Marketing thường liên quan đến nhiều nền tảng, nhiều đối tác và phòng ban, vì vậy lượng dữ liệu cũng rất lớn và đa dạng nguồn. Tốc độ thay đổi về dữ liệu và công cụ cũng diễn ra không ngừng.

Vì vậy, việc data lưu trữ rời rạc, phân mảnh nhiều nơi sẽ tạo không ít thách thức cho marketer như:

1. Tốn thời gian tập trung dữ liệu: Marketer phải dành quá nhiều giờ để “nhặt nhạnh” dữ liệu thay vì phân tích.

2. Thiếu cái nhìn toàn diện, dễ sai sót: Rất dễ sai khi chỉ nhìn từ một kênh hay báo cáo lẻ.

3. Lãng phí tiềm năng: Cần nhiều thời gian để xử lý tay dữ liệu mỗi lần làm báo cáo, trong khi thời gian đó nếu tiết kiệm được có thể tập trung vào việc tối ưu hóa chiến dịch, tăng hiệu quả công việc và tạo ra giá trị lớn hơn cho doanh nghiệp.

Data Centralization: Chìa khóa giúp Marketer làm chủ dữ liệu:

Tin tốt là việc tập trung hóa dữ liệu (data centralization) ngày nay đã trở nên khả thi và hiệu quả hơn rất nhiều về cả ngân sách và kỹ thuật. Data centralization không chỉ là một giải pháp kỹ thuật mà là một chìa khóa chiến lược giúp bạn chuyển từ vị thế phản ứng sang chủ động. Bằng cách hợp nhất dữ liệu, bạn có thể xây dựng “một nguồn chân lý duy nhất”, cung cấp cái nhìn toàn diện hơn về khách hàng và thị trường.

Xây dựng data warehouse và Dashboard từ 2 Không:

– KHÔNG KỸ SƯ:

Mình vốn không có nền tảng IT, dân Marketing và Truyền thông thuần túy, đầu toàn chữ. Tuy nhiên, mình đã tự học qua các khóa học của Google, bắt đầu xây dựng việc tập trung các nguồn dữ liệu của team vào Big Query với các công cụ miễn phí đến rất rẻ sau đây: Coefficients, Google Sheets, Big Query.

Nói như thế không có nghĩa là mình có thể thay thế được các bạn Kỹ sư dữ liệu (Data Engineer), mà mình muốn chia sẻ rằng với một nhu cầu của một phòng ban nhỏ và linh hoạt như marketing, chúng ta hoàn toàn có thể tự bắt đầu với các giải pháp low-code (ít lập trình) và kỹ năng SQL cơ bản. Các bạn Data Engineer vẫn luôn cần thiết với các dự án có tính hệ thống, liên quan nhiều bên và phức tạp hơn.

– KHÔNG CHI PHÍ :

Năm đầu tiên, với nhu cầu cơ bản của marketing và tinh thần “liệu cơm gắp mắm”, mình gần như không phát sinh chi phí gì, đến cả connectors mình cũng chia nhỏ dữ liệu ra thành nhiều batch (lô) để truyền về warehouse, kết hợp 10TB miễn phí của Big Query cho lưu trữ và xử lý thì team mình không mất đồng nào, trừ công sức xây dựng và xử lý.

Đến năm thứ 2, sau giai đoạn thử nghiệm, chúng mình nhận ra được giá trị của dữ liệu trong tối ưu hóa kết quả nên đã quyết định đầu tư bài bản. Lúc này, tụi mình:

– Sử dụng connectors trả phí để cho việc kết nối và truyền dữ liệu phục vụ được lượng dữ liệu lớn hơn

– Tái cấu trúc lại hệ thống data warehouse, xây dựng các mô hình phân tích lớn hơn, phức tạp hơn. Do đó, cũng phát sinh chút ít chi phí cho phần lưu trữ và xử lý dữ liệu nhưng không nhiều.

Nhìn chung, việc đầu tư vào dữ liệu là tầm nhìn dài hạn và sẽ luôn cần sự đầu tư lâu dài về kỹ năng, ngân sách. Tuy nhiên, nó không nhất thiết phải phức tạp và tốn ngân sách quá lớn từ đầu. Mình có liệu kê dưới đây 5 bước để bạn và team tham khảo cách triển khai:

Bước 1: Xác định nguồn dữ liệu

Cái này thì khá đơn giản, hãy liệt kê tất cả các nguồn dữ liệu mà bạn đang sử dụng hoặc đang có mà chưa sử dụng, mình điểm danh một số nguồn quen thuộc dưới đây:

- Dữ liệu khách hàng (Customer Data): CRM, Loyalty programs

- Dữ liệu giao dịch: Thông tin bán hàng từ POS, thương mại điện tử (Shopee, Tiktokshop, Lazada, Tiki…) ,…

- Dữ liệu quảng cáo và kênh truyền thông như: nền tảng chạy quảng cáo (Facebook Ads, Google Ads, Tiktok Ads,…) , mạng xã hội, Email marketing, website analytics như GA4, Microsoft Clarity

- Dữ liệu nội bộ: ERP, Sự kiện, Khảo sát,…

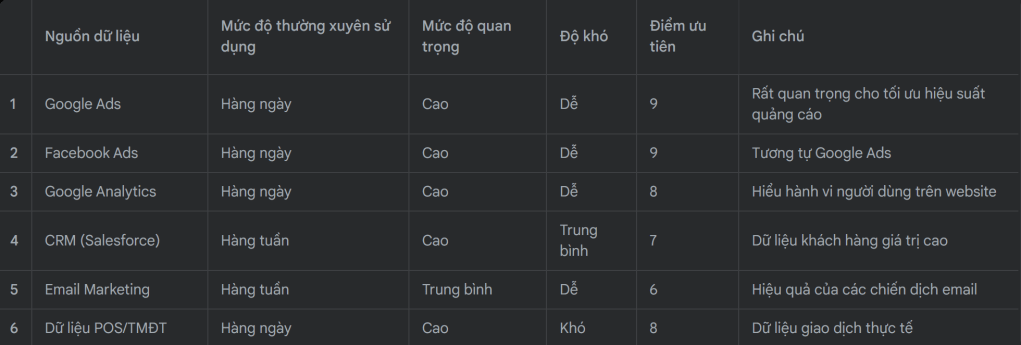

Bước 2: Đánh giá mức độ ưu tiên nguồn dữ liệu

Không phải tất cả dữ liệu đều quan trọng như nhau. Sau khi liệt kê, hãy đánh giá và ưu tiên nguồn nào nên được tập trung hóa trước dựa trên 3 yếu tố:

- Mức độ thường xuyên sử dụng: Dữ liệu nào bạn hoặc đội ngũ sử dụng hàng ngày/tuần để ra quyết định?

- Mức độ quan trọng: Dữ liệu nào có tác động lớn nhất đến hiệu quả chiến dịch, ROI, hay hiểu biết về khách hàng?

- Độ khó: Dữ liệu nào dễ trích xuất, có cấu trúc rõ ràng hay cần nhiều công sức để làm sạch và chuẩn hóa?

Bạn có thể tạo một bảng đơn giản và gán điểm để có thứ tự ưu tiên rõ ràng.

Ví dụ một bảng mẫu như sau:

Bước 3: Chọn kho lưu trữ dữ liệu (Data Warehouse) & Công cụ kết nối (Connectors):

Để lưu trữ dữ liệu tập trung, bạn cần một kho dữ liệu (Data Warehouse). Đây là nơi an toàn và hiệu quả để tổng hợp, lưu trữ và xử lý lượng lớn dữ liệu từ nhiều nguồn khác nhau.

Với nhu cầu của các nguồn dữ liệu Marketing, mình chọn Google BigQuery – một dịch vụ kho dữ liệu đám mây (cloud data warehouse) dựa trên một số ưu điểm sau đây:

- Miễn phí 10TB đầu tiên và linh hoạt theo dung lượng sử dụng: BigQuery cung cấp 10TB dữ liệu miễn phí cho lưu trữ và truy vấn, rất phù hợp cho nhu cầu nội bộ phòng ban. Khi vượt ngưỡng này, chi phí sẽ được tính dựa trên lượng dữ liệu bạn lưu trữ và truy vấn, nhưng nhìn chung chi phí vẫn rất cạnh tranh và linh hoạt.

- Thân thiện với người dùng non-dev: Nhiều tác vụ cơ bản như kết nối data, kết nối bảng có thể thao tác trực tiếp từ giao diện web (UI) trực quan của BigQuery, giúp bạn dễ dàng bắt đầu.

- Tích hợp tốt với các nguồn dữ liệu Marketing: BigQuery kết nối dễ dàng với các nguồn dữ liệu của Google như Google Ads, Google Analytics, v.v.

Việc thiết lập BigQuery cơ bản có thể chỉ mất vài giờ, nhưng để tích hợp và đưa dữ liệu từ tất cả các nguồn vào một cách có hệ thống, bạn có thể cần từ vài tuần đến tháng, chủ yếu tùy thuộc vào số lượng và độ phức tạp của các nguồn dữ liệu.

Thông tin thêm về Big Query: https://cloud.google.com/bigquery/docs/introduction

Tiếp theo, để đưa dữ liệu từ các nguồn khác nhau vào data warehouse, bạn có thể chọn lựa giữa hai phương án:

- Tự code bằng Python: phương án này thì chi phí thấp, chủ yếu tốn thời gian nếu có nhiều nguồn dữ liệu và cần kiến thức, kỹ năng code Python

- Sử dụng các API/ Connectors: Đây là những “cây cầu” tự động hóa việc trích xuất và tải dữ liệu từ các nguồn về data warehouse. Mình có nhờ AI tổng hợp và đánh giá một số lựa chọn dưới đây để bạn tham khảo nhé

Bước 4: Thực hiện kết nối và xử lý dữ liệu

Sau khi dữ liệu được đưa vào Data Warehouse, bước tiếp theo là xử lý và chuyển đổi chúng thành thông tin có giá trị. Hiện nay, có hai cách tiếp cận chính với việc kết nối và xử lý dữ liệu thô:

- ETL (Extract, Transform, Load): Dữ liệu được trích xuất (Extract), sau đó được chuyển đổi (Transform) (làm sạch, chuẩn hóa, tổng hợp) trước khi được tải (Load) vào kho dữ liệu.

- Ưu điểm: Dữ liệu được làm sạch và chuẩn hóa trước khi vào Data Warehouse, giúp kho dữ liệu “sạch” và dễ quản lý hơn. Phù hợp với các hệ thống cũ, khi năng lực xử lý của Data Warehouse còn hạn chế.

- Nhược điểm: Tốn thời gian cho bước chuyển đổi trung gian. Nếu cần thay đổi yêu cầu chuyển đổi, bạn phải chạy lại toàn bộ quy trình từ đầu. Yêu cầu hạ tầng xử lý bên ngoài Data Warehouse.

- Ví dụ ứng dụng trong Marketing: Bạn muốn chuẩn hóa tất cả các định dạng tên sản phẩm từ các kênh TMĐT khác nhau trước khi đưa vào BigQuery để đảm bảo tính nhất quán cho việc báo cáo.

- ELT (Extract, Load, Transform): Dữ liệu được trích xuất (Extract) từ nguồn, sau đó được tải (Load) ngay lập tức vào kho dữ liệu đích (Data Warehouse). Bước chuyển đổi (Transform) sẽ diễn ra bên trong kho dữ liệu, sử dụng sức mạnh xử lý của chính Data Warehouse.

- Ưu điểm: Tận dụng tối đa sức mạnh tính toán của BigQuery, linh hoạt hơn vì dữ liệu thô luôn có sẵn để biến đổi theo nhiều cách khác nhau.

- Nhược điểm: Dữ liệu thô được lưu trữ trong Data Warehouse, có thể chiếm nhiều dung lượng ( tuy nhiên, chi phí lưu trữ trên đám mây hiện nay không quá đắt).

- Ví dụ ứng dụng trong Marketing: Bạn truyền (stream) toàn bộ dữ liệu từ Google Ads và Facebook Ads vào BigQuery. Sau đó, bạn dùng SQL trực tiếp trong BigQuery để tổng hợp, tính toán CPA (Cost Per Acquisition) cho từng chiến dịch.

Bạn có thể tham khảo Khóa học cơ bản làm quen với SQL và Big Query của Google tại đây nhé: https://www.coursera.org/professional-certificates/google-cloud-data-analytics-certificate

Bước 5: Sao lưu (back up) và đối chiếu dữ liệu thường xuyên

Một khía cạnh thường bị bỏ qua nhưng cực kỳ quan trọng trong quản lý dữ liệu là sao lưu (backup) và đối chiếu dữ liệu. Ngay cả với các hệ thống tự động hóa tiên tiến nhất, lỗi vẫn có thể xảy ra, hoặc dữ liệu nguồn có thể thay đổi bất ngờ.

- Tầm quan trọng:

- Phòng ngừa lỗi: Giúp khôi phục dữ liệu về trạng thái trước đó nếu có lỗi trong quá trình đồng bộ hoặc xử lý

- Giải quyết tranh chấp: Nếu có sự khác biệt về số liệu giữa các phòng ban hoặc với đối tác, bạn có thể dựa vào dữ liệu gốc đã sao lưu để đối chiếu.

- Thực hiện sao lưu và đối chiếu:

- Tạo bản sao mỗi ngày: Đối với các nguồn dữ liệu quan trọng và thường xuyên thay đổi (như dữ liệu từ hệ thống CRM, dữ liệu giao dịch), hãy tạo quy trình tự động tạo bản sao lưu (snapshot) hàng ngày trong một dataset riêng biệt bằng cách cấu hình trong connectors, hoặc viết lệnh bằng Python.

- Kiểm tra tính toàn vẹn (Data Integrity Checks): Định kỳ (hàng ngày hoặc hàng tuần), hãy chạy các truy vấn SQL đơn giản để so sánh tổng số dòng, tổng giá trị các chỉ số quan trọng (ví dụ: tổng chi phí quảng cáo, tổng doanh thu) giữa dữ liệu đã sao lưu và nguồn gốc.

- Thiết lập cảnh báo (Alerts): Cân nhắc thiết lập các cảnh báo tự động nếu có sự chênh lệch lớn (ví dụ: >5%) giữa dữ liệu trong Data Warehouse và dữ liệu nguồn, hoặc nếu quá trình đồng bộ bị lỗi.

Bài hôm nay khá dài và có lẽ hơi nặng cho người mới bắt đầu, nhưng nếu bạn đủ kiên nhẫn đọc đến cuối bài, mình nghĩ bạn sẽ đủ kiên trì để học, thử và dần dần làm chủ dữ liệu và từ đó nâng cao hiệu quả của các hoạt động marketing của mình.

Cheers,

Bài viết gần đây:

- 2 tập dữ liệu và 1 lá thư đã giúp Continental Airlines lội ngược dòng danh tiếng như thế nào?

- Marketing – Nạn nhân lớn nhất của dữ liệu phân mảnh và 5 bước khắc phục

- Doanh thu từ quảng cáo tăng, nhưng tổng doanh thu vẫn đứng im: Chuyện gì đang xảy ra?!

- Dữ liệu rẻ, insight đắt: Cuộc chơi mới của marketer

- Dashboard và Report: Dùng sao cho hiệu quả

Leave a comment